2024-05-28 14:29:48 西盟科技资讯

近日,由极客邦旗下 InfoQ 中国倾力打造的 AICon 全球人工智能开发与应用大会在北京举办。此次大会以“智能未来,探索 AI 无限可能”为主题,汇聚 60 位行业头部企业嘉宾,带来精彩纷呈的见解与分享。

作为大会核心论坛之一,“大模型 + 行业创新应用”专题论坛于5月18日如期举行,聚焦金融、法律、医疗、教育等不同领域,探讨分享大模型技术在各自领域内的应用经验和深刻洞见,推动大模型技术的有效落地和行业创新。云知声 AI Labs 研发副总裁刘升平应邀出席论坛并发表《山海医疗大模型的构建及其应用实践》主题演讲。

深耕人工智能产业多年,云知声一直密切关注AI前沿技术在医疗领域的创新应用。入局智慧医疗赛道以来,云知声针对医疗行业各场景痛点,陆续研发推出了语音电子病历、智能病历质控、单病种质控、智能医保审核等多款智慧医疗产品,覆盖医政医管、临床诊疗、医保管理、患者服务等多个医疗业务环节。山海大模型发布后,云知声更是基于山海医疗行业版大模型,全面升级了医疗业务线各产品智能化水平,发布门诊病历生成系统、手术记录撰写助手、商保智能理赔系统等医疗产品应用,实现从助手到专家的跃迁。

现场,刘升平深入剖析医疗大模型应用价值,并基于山海医疗大模型的构建与实际落地探索,分享了大模型在特定行业中的定制化优化策略。

以下为分享精华,我们做了整理,谨供学习:

医疗大模型:技术突破与行业应用实践

在深入探讨医疗大模型之前,我们首先需要了解在拥有通用大模型的基础上,为什么还需要行业特定的大模型。

刘升平指出,通用大模型虽然能力强大,但它们缺乏针对特定行业的深入理解和优化,而行业大模型正是为了弥补这一空缺而诞生的,它们基于行业知识和任务进行深度学习和优化,从而在各自领域内成为专家级的解决方案。

当前市场上的医疗大模型主要分为四大类别:通用模型、医学文本模型、临床多模态模型以及生物医药模型。作为通用大模型的代表,山海医疗大模型以其卓越的性能和专业能力脱颖而出。在CCKS 2023 PromptCBLUE医疗大模型评测中,山海模型荣获通用赛道一等奖,证明了其在多任务学习和应用上的广泛适用性。此外,在MedBench评测中,山海模型以54.7的高分荣获榜首,这一成绩充分展示了其在医疗领域深度理解和精准应用的专业实力。

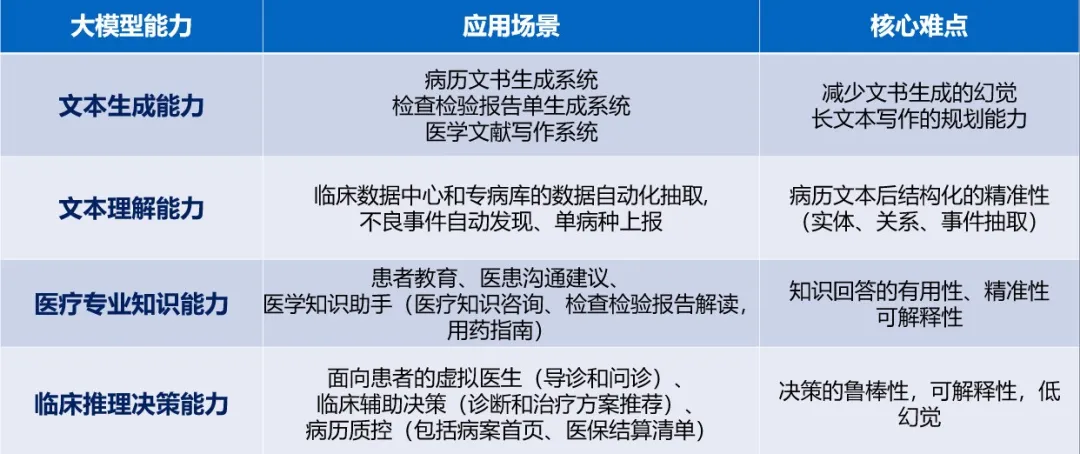

依据大模型的核心能力,云知声将医疗大模型的应用场景细致划分为四大类别:生成类、理解类、知识类和决策类,以实现对医疗领域不同需求的精准覆盖。

现场,刘升平分享了山海医疗大模型在具体场景的落地应用,引起与会者的广泛关注与思考。

针对门诊场景中的病历撰写需求,云知声门诊病历生成系统以山海医疗大模型为依托,应用前端声音信号处理、智能语音识别等技术,结合庞大的医疗知识图谱,实现了诊室复杂环境下的降噪、医患角色区分、信息摘要及病历自动生成等功能,有效提升病历书写效率,切实为医务人员减负。

针对医疗质量管理中的病历审核需求,云知声依托山海医疗大模型,结合详尽的医疗规范和标准数据库,打造智能病历质控系统,该系统可准确理解病历内涵并进行缺陷筛查,重塑业务流程,大幅提高病历质控工作效率,以及质控的深度和广度。

针对商业保险理赔中的医疗费用审核需求,云知声以山海医疗大模型和医疗知识图谱为底层技术支撑,结合医疗文书OCR,构建商保智能监管与审核系统,通过智能录入、规则配置、智能AI审核、审核报告生成四步走,打造具有医学知识和保险理赔经验的虚拟审核员。

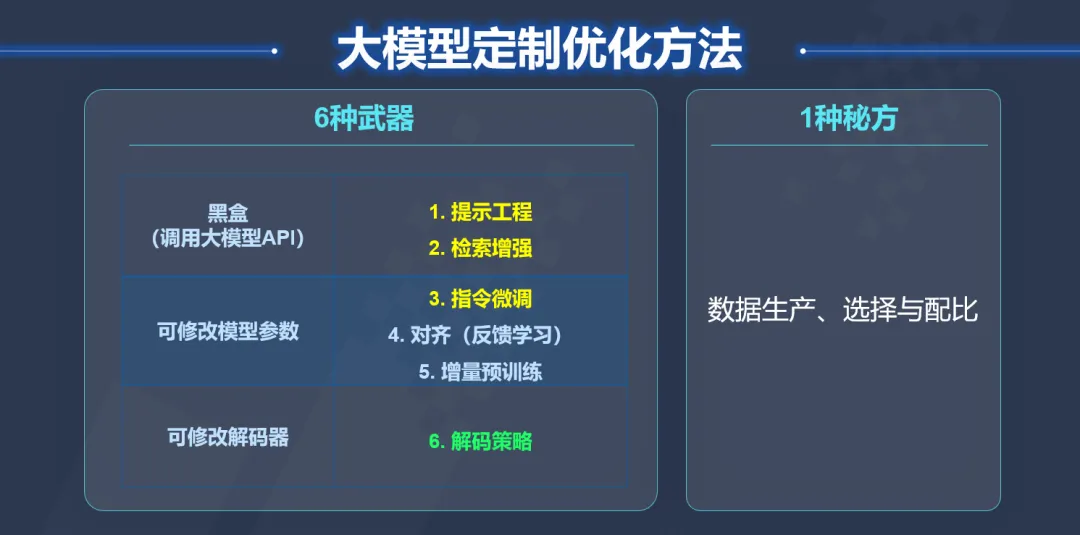

云知声面向应用的行业大模型定制优化策略:6种武器+1种秘方

论坛现场,刘升平结合云知声自身实践经验,分享了面向应用的行业大模型定制优化的6种武器和1种秘方,这些策略共同构成了一套全面的方法论,确保了山海医疗大模型能够在实际应用中达到最佳效果。

6种武器

提示工程:通过创造性地设计“咒语”,即输入提示,引导大模型沿着清晰的思维链进行逻辑推理,使其更准确地理解任务需求并生成合适的响应。结合ICL(In-Context Learning),提示工程不仅关注于单个任务的执行,还强调了上下文信息的重要性,使模型能够在特定情境中学习,利用上下文信息来提高生成回答的相关性和准确性,有助于减少模型在生成回答时可能出现的幻觉,即模型生成与现实不符的输出。

检索增强:通过整合外部知识库,让模型能够检索并利用相关信息,从而提供更准确和全面的答案。其核心在于允许模型在生成回答时,动态地检索并利用最新的外部信息,通过减少模型依赖于内部知识的限制,有效降低了生成错误信息的风险,使得模型在处理需要广泛背景知识或实时数据的任务时,表现得更为出色。

指令微调:通过针对性的训练数据,优化模型对特定指令的响应能力,提升模型执行特定任务的效率。通过数据构造、数据合成、指令数据优选与配比等关键步骤,不仅提高了模型对特定指令的响应速度和准确性,还增强了模型在特定任务上的执行效率。

对齐(反馈学习):对齐是确保模型输出与用户需求保持一致性的过程,它通过整合用户的反馈来引导模型的持续学习和自我优化。在这个过程中,模型不仅学习用户的直接反馈,还从用户的行为中提取隐式的反馈信号。利用这些反馈,模型能够自动识别和纠正生成内容中的错误,实现自我纠错。

增量预训练:增量预训练是一种持续提升模型性能的策略,它允许模型通过定期引入新的数据进行学习,以适应不断变化的知识环境。这个过程不仅涉及到数据的更新,还需要强大的算力和精细的数据工程支持。

解码策略:根据不同的应用场景,大模型推理可设置不同的解码策略。针对创意内容生成或行程安排等场景,可采取Sample Search、Top-P、Top-K Sample等基于采样概率的解码策略,增加输出的创造性和选择性;针对选择、推理等答案相对确定的场景,可采取Greedy Search、Beam Search等基于最大概率的解码策略。此外,还可以采取引入辅助模型实现的对比策略和猜测策略,借鉴AlphaGo实现的树搜索解码策略等。

1种秘方

数据的生产、选择与配比,是确保模型性能最大化的关键步骤。在这一过程中,数据的质量和多样性直接影响到模型的学习和泛化能力。

数据生产涉及到收集、生成和整理用于训练和微调模型的数据。这不仅包括公开可用的数据集,也包括特定于行业的专有数据。

数据选择是指从大量可用数据中挑选出对模型训练最有价值的部分。这一步骤要求我们理解模型的需求和任务的特性,以便选择能够最大化模型性能的数据。

数据配比涉及到不同类型和来源数据的混合和权重分配。正确的配比策略可以强化模型对关键特征的学习,同时减少对噪声和不相关信息的敏感性。

综合来看,大模型的定制优化可采取多层次策略,以适应不同算力条件并提升模型效果——在算力有限的情况下,通过调用大模型API并运用提示工程、检索增强结合知识增强等技术来解决实际问题;当算力适中,拥有1至20台服务器时,可通过指令微调、解码策略优化以及对齐优化(反馈学习)来进一步优化任务性能;对于算力充足的情况,既可以在开源底座模型上进行增量预训练,还可以从零开始预训练自己的底座模型,以实现模型性能的根本性提升。