2026-02-14 12:15:33 西盟科技资讯

OpenClaw从个人AI助手走向企业数字员工,正成为中小企业提质增效的AI利器。然而,在企业部署OpenClaw的实际过程中,其作为多Agent调度平台,部署效率、并发性能和数据安全合规等问题也随之出现。

围绕OpenClaw支撑多Agent的场景,浪潮信息基于元脑x86服务器完成系统级压力测试与工程验证,正式发布业界首份智能体宿主机性能评测报告:在192核/384线程高密度算力配置下,元脑x86服务器单机可稳定运行96路Agent实例,并支撑数百路并发业务会话,支持DeepSeek、Qwen、Kimi等主流Agent基座大模型调用,满足企业级多用户、多任务场景的实际需求,同时支持一键式配置镜像导入,为企业提供快速部署、高效稳定的算力底座。

OpenClaw企业部署需求火爆,但模型跑得动Agent带不动

随着AI智能体从技术演示走向规模化应用,企业私有化部署需求持续升温。OpenClaw凭借多任务调度与自动化能力,成为AI领域的24小时“数字员工”,但在企业私有化实际部署中却面临一系列问题:

模型跑得动,百路Agent带不动。随着Agent深入企业日常办公、财务、研发、供应等各个环节办公场景,模型调用和工具调用次数高速增长,千亿甚至万亿参数大模型的硬件算力昂贵,处理Agent计算存在资源浪费且会出现性能瓶颈。一个完整的 Agent 任务,需要经历任务解析、规划决策、工具调用、结果整合等多个阶段,其中大量工作发生在模型之外,对 CPU 并发调度、上下文切换、生态成熟度等能力提出了更高要求。在IT预算整体受限和降本增效压力加剧的背景下,企业必须考虑底层架构选型与性能优化,保证系统的执行力、稳定性与并发上限。

智能体平台部署效率低。OpenClaw部署是企业私有化落地智能体面临的又一难题。其本地部署并非简单安装软件,一般需要IT管理人员手动安装Docker、OpenClaw等工具,连接基座大模型,管理人员需为Agent设置繁琐的环境变量,极易出现依赖冲突、构建失败、版本不兼容或模型无法调用等异常。对于非专业运维人员,常常会陷入反复排错与重复部署的循环,导致整个部署周期长,影响AI业务上线速度。

数据安全与合规保障难。企业级AI应用涉及敏感数据,包括客户信息、财务数据、研发资料等商业机密信息,这些数据在OpenClaw的处理流程中需经历输入、处理、输出和存储多个环节,私有化部署必须确保数据在每个环节都得到充分保护,且数据不出企业。而且OpenClaw针对每一个用户的运行环境、数据存储都必须是独立的,保证服务器部署 OpenClaw 架构的安全性和可控性。更为复杂的是,未来多智能体架构意味着数据可能在多个容器、多个进程间流转,每个数据交换点都可能成为安全漏洞。企业需要建立完善的数据流向监控体系,实现细粒度的访问控制,包括基于角色的权限管理、最小权限原则的实施,以及完整的操作审计追溯能力。

元脑x86服务器,单机支撑96路OpenClaw并发

OpenClaw作为多Agent调度系统,其并发能力高度依赖整机的多核并行、I/O架构与资源隔离能力。浪潮信息基于元脑x86服务器,通过穷举CPU和内存的限制组合,实测确认容器最低配置为4vCPU+4GB内存。依托192核/384线程的高密度算力,结合x86服务器成熟的虚拟化与容器生态,元脑x86服务器在多核调度、NUMA感知、资源隔离及I/O协同方面实现单机稳定运行约96路Agent实例,并可支撑数百路并发会话,该能力已在大规模生产环境中得到充分验证。

高密度算力配置,单机稳定运行近百路Agent实例。元脑x86服务器依托192核/384线程的高密度算力,结合x86服务器成熟生态环境和调优工具,实现单机稳定运行约96路Agent实例,支持数百路并发会话。同时,通过在BIOS中精准调优Latency Optimized Mode(enabled)、Page Policy(adaptive)与Sub-Numa Cluster(enabled)等核心参数,元脑x86服务器显著降低内存访问延迟。

实测数据显示,跨Socket内存访问延迟降低35%,有效缓解NUMA架构下的跨节点访问问题,近端内存访问延迟降低10%,这一改进大幅提升了虚拟化环境中CPU、内存等资源的协同效率,减少了性能抖动。基于自研InBry BMC(采用OpenBMC架构)精准识别系统Workload特征,动态调整散热策略,在保障关键部件散热能力的同时,整机系统效能提升15%,实现性能与能效的最优解。元脑x86服务器各组件软硬件设计进行深度定制融合,自主创新开发故障诊断专家规则库,对服务器进行全生命周期的工作健康状态实时监测、预警,例如故障诊断模块(DMPU)将根因定位准确度提升至95%,内存故障智能预警修复技术(MUPR)将内存导致的宕机故障率降低80%,保障系统稳定运行。

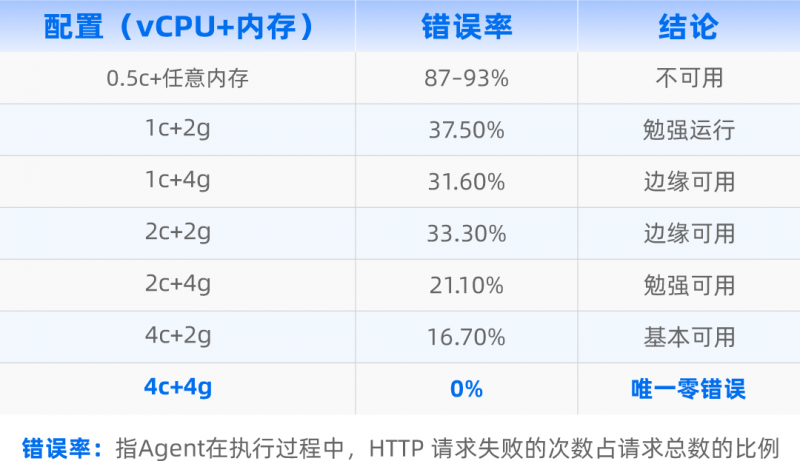

表1 不同CPU和内存组合的容器测试结果

测试表明,OpenClaw在低核环境下错误率显著上升,而达到企业级配置后,系统可实现7×24小时稳定运行,内存增长可控,复杂工具调用场景下未出现崩溃。

如下是元脑x86服务器部署OpenClaw的容器列表、运行状态与执行结果:

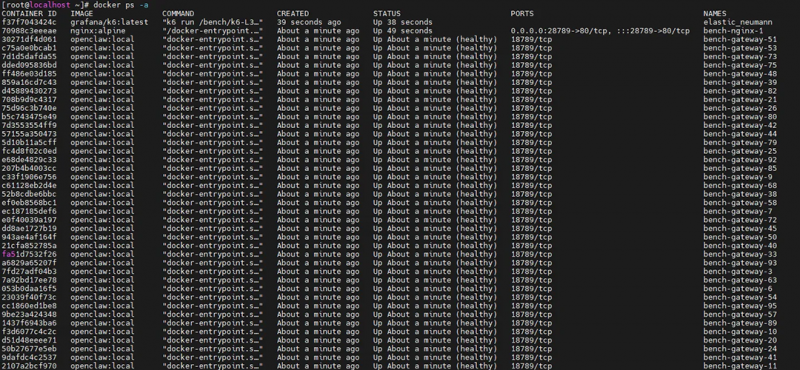

图1 容器建立

基于单台192核的x86服务器,成功部署96个容器,为每路Agent提供独立执行环境

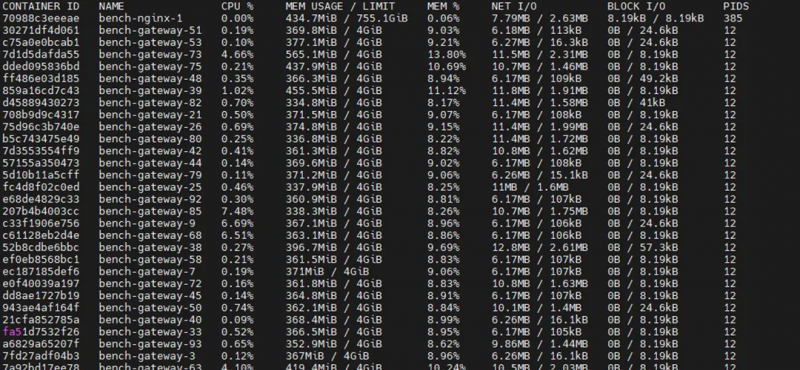

图2 容器运行状态

展示各容器CPU、内存、网络I/O等资源使用情况,所有容器均正常运行

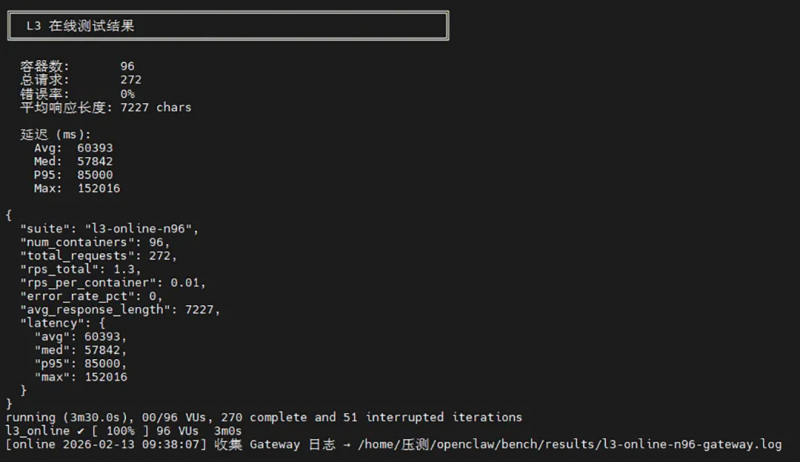

图3 Agent任务执行结果

每个容器并发执行任务,每个任务输入约200 tokens,全部成功完成

表2 OpenClaw 在 Agent 场景下的关键系统特征(实测)

基于实测数据,元脑x86服务器为渠道伙伴和企业用户提供快速配置方案和优惠价格,中小团队仅需单台高核心数服务器即可满足百路Agent需求,中大型企业可通过多机扩展灵活支撑,所列产品均为完整配置并可即刻发货,助力用户快速部署落地OpenClaw智能体应用。

表3 企业私有化部署OpenClaw推荐配置

一键式配置导入,方便渠道伙伴和客户快速部署OpenClaw。在x86服务器上部署OpenClaw需要经过容器构建、源码克隆和配置本地模型三个步骤,例如构建容器需要配置CPU、内存、磁盘、网络、端口等参数,保证每一个实例使用独立的 profile、state、config、workspace 及端口;源码克隆并配置MODEL_PROVIDER、Channel 、API_KEY、Skills、Hooks等繁多环境参数,保证OpenClaw连接大模型、可运行、开启高级功能等。浪潮信息将这些参数设置打包成一个配置镜像,渠道伙伴和客户无需逐一处理容器参数设置与模型连接、功能启用等繁琐步骤,即可快速完成OpenClaw的部署,有效避免因参数遗漏、前后配置不一致等问题导致的部署失败,显著提升部署效率与准确性。

容器化隔离,支持多用户安全隔离。在安全层面,用户可通过元脑x86服务器离线部署,确保数据100%留存在企业内部。并且该产品在多租户环境中,采用“一用户一实例”的部署方案,为每位用户独立部署一个OpenClaw实例,每个OpenClaw实例均具备独立资源、独立存储与独立网络端口,实现会话记忆、文件空间与运行状态的逻辑与物理双重隔离,确保不同Agent用户间互不干扰且安全可控。即便容器里的程序被恶意利用,容器都有独立的用户空间和文件空间,也无法直接影响宿主系统或其他容器。

AI Agent正在从“工具”走向“基础设施”。企业真正需要的,不只是能跑的Agent,而是一个在工程层面确定性足够高、并发能力清晰可控的智能体运行底座。

元脑x86服务器凭借高密度算力配置、成熟的虚拟化与容器生态,以及对复杂Agent负载的工程级验证,为企业级部署OpenClaw提供了稳固可靠的业务基石,助力企业将 AI 从“技术探索”真正转化为“可持续的业务能力”。