2026-02-06 11:29:56 中华网

2026年2月4日,上海人工智能实验室开源基于“通专融合”技术架构SAGE打造的万亿参数科学多模态大模型Intern-S1-Pro,为AI4S从“工具革命”的1.0阶段迈向以“革命的工具”驱动科学发现的2.0时代,提供了创新的系统性开源基座。昇腾AI基础软硬件为该模型的训练和推理提供了全流程支持。

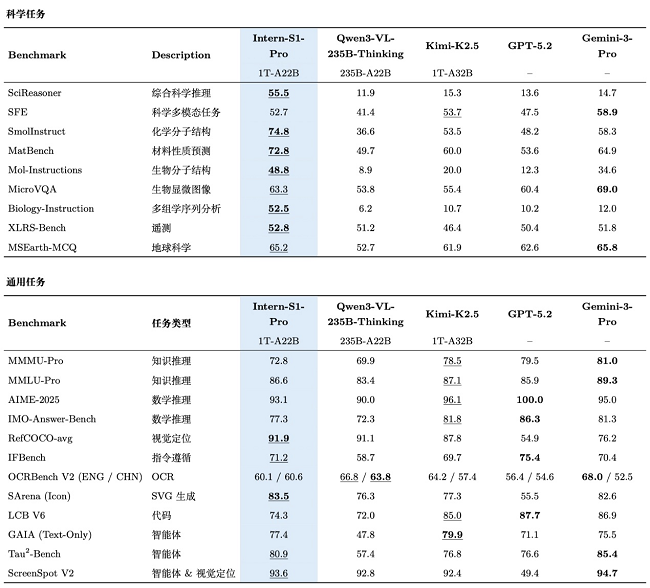

作为当前全球开源社区中参数规模最大的科学多模态模型,Intern-S1-Pro的核心科学能力实现了质的跃升,高难度综合学科评测稳居AI4S领域国际领先水平,复杂数理逻辑推理能力达奥赛金牌水平,面向真实科研流程的智能体能力位居开源模型第一梯队。Intern-S1-Pro旨在降低全球科研门槛,与学术界和产业界共同推动以通用人工智能驱动科学发现的范式革命。

此次发布的Intern-S1-Pro是通过SAGE实现“可深度专业化通用模型”的关键实践。该模型基于混合专家架构(MoE),共拥有512个专家,总参数达1T,每次调用仅激活8个专家、22B参数。其通用能力和科学能力协同演进,并在底层架构实现了两大核心突破:在SAGE的基础模型层,通过引入傅里叶位置编码并重构时序编码器,赋予模型统一理解从微观生命信号到宏观宇宙波动的“物理直觉”;通过高效路由机制,系统攻克了训练万亿参数MoE模型在稳定性与算力效率上的瓶颈,为超大规模模型的训练提供了关键的工程基础。

Intern-S1-Pro开发团队依托产品日益成熟、生态持续完善的昇腾算力平台,与昇腾AI生态深度适配,基于自主创新的训练与推理框架,为构建开放共享的AGI4S基础设施奠定了坚实底座。该底座完整支撑了从模型训练、推理到自动化评测的全流程闭环,构筑了从原创模型架构到自主创新算力基座的完整技术链路,充分展现了昇腾AI生态在支撑高精度、高性能、强稳定、低成本超大规模AGI4S前沿模型上已非常成熟可靠。这为前沿模型的持续高效迭代与快速成熟铺平了道路,将有力支撑其更广泛的应用部署。

目前,昇腾A3超节点产品已能全面满足Intern-S1-Pro在万亿级MoE架构下的训练与推理需求。基于深度适配的XTuner框架,系统在FSDP2的基础上,进一步支持了Intra-Node Domino-EP的双batch间计算通信掩盖、swap activation/optimization等内存优化特性,使昇腾A3超节点在万亿MoE模型训练场景下仍能够实现较高的吞吐性能。同时,LMDeploy与vLLM Ascend已支持Intern-S1-Pro的多机推理部署,并通过动态量化、ACL Graph等特性进一步释放推理性能潜力。

昇腾一直致力于构建开放的AI技术生态,积极参与AtomGit AI社区、魔乐社区、Gitee AI社区、启智社区等生态社区的共建,让开发者能够快速获取昇腾适配的模型、算法、工具等能力和源码。此次Intern-S1-Pro模型一经发布开源,即同步上线AtomgGit AI社区和魔乐社区,欢迎开发者们下载。

在线体验链接:

https://chat.intern-ai.org.cn/

AtomGit AI链接:

https://ai.gitcode.com/InternLM/Intern-S1-Pro

魔乐社区链接:

https://modelers.cn/models/Intern/Intern-S1-Pro

GitHub链接:

https://github.com/InternLM/Intern-S1

HuggingFace链接:

https://huggingface.co/internlm/Intern-S1-Pro

ModelScope链接:

https://www.modelscope.cn/models/Shanghai_AI_Laboratory/Intern-S1-Pro

创新底层架构:突破万亿参数科学模型边界

Intern-S1-Pro通过多项SAGE基础模型层的技术创新,拓宽了模型应用边界、提升了超大规模训练可行性,推进了可深度专业化通用模型的探索。

为构建能更深层次理解物理世界规律的科学大模型,研究团队引入了傅里叶位置编码(FoPE)并重构时序编码器。FoPE为AI赋予双重视角:既能像看“粒子”一样捕捉文字之间的相对距离,又能像分析“波”一样把握科学信号的整体规律与频率。科学数据与语言的差异还体现在多尺度上,基于能自动适应数据密度的时序编码器,模型首次能统一处理从寥寥数个到百万级采样的各类信号,支持的分析对象从天文、地理直接拓展至生理信号、生物声学等领域,从而实现感知能力的重大跃迁。

为了高效训练承载这些能力的万亿参数超大规模模型,研究团队革新了其内部的“路由机制”。传统方法存在训练低效和算力浪费两大痛点。新技术通过“路由稠密估计”,让模型在高效运行的同时能进行更充分的学习,提升了稳定性;进而通过“分组路由”策略,像智能交通系统一样使海量计算芯片实现负载均衡,避免了资源闲置,能更加充分地利用昇腾超节点的通信带宽,释放NPU的强劲算力。通过算法与系统的协同创新,同时攻克了超大规模模型训练在“学习效率”和“资源调度”上的核心瓶颈,为高效、稳健地训练下一代万亿参数模型提供了关键基础。

通过上述底层架构的创新,Intern-S1-Pro不仅在规模上刷新了科学多模态模型的参数规模上限,也为SAGE架构所提出的“通用能力与专业能力协同演进”提供了可落地的实现路径。

科学能力再进化,通用能力协同演进

得益于创新的底层架构设计与万亿参数超大规模训练策略,Intern-S1-Pro的科学能力进一步升级。

在AI4S关键垂类领域,Intern-S1-Pro成功构建了一个跨越化学、材料、生命、地球、物理五大核心学科的全谱系能力矩阵,涵盖100多个专业子任务,不仅在Mol-Instruction、Biology-Instruction等单学科垂类评测中表现优异,更在SciReasoner、SFE等高难度的综合学科评测基准中,取得了与闭源商业大模型及垂类SOTA模型相当,甚至更优的成绩,稳居AI4S领域的第一梯队,展现出从“解题”迈向“解决问题”的科研生产力价值,为前沿科学探索提供了坚实支撑。在国际数学奥林匹克IMO-Answer-Bench和国际物理奥林匹克IPHO2025两大权威基准测试中,Intern-S1-Pro均达到国际顶尖水平,展现出竞赛级别的解题能力。

同时,借助通专融合技术路线,Intern-S1-Pro实现了多模态与文本通用能力的均衡发展,在通用能力与专业科学能力上协同进阶:在图文跨模态理解、科学图表逻辑推理、多场景视觉感知,以及高质量自然语言生成和复杂指令精准遵循等核心维度,Intern-S1、Intern-S1-Pro均稳居开源模型阵营第一梯队,展现出扎实而全面的综合实力,为科研场景下复杂问题的理解、推理与应用提供了可靠支撑。

在智能体能力方面,Intern-S1-Pro实现了从“静态任务规划”到“动态环境交互”的跨越式进阶。在以动态环境与复杂交互为核心的Tau-2评测中达到了国际一流水平,为赋能复杂科学智能体打下了坚实基础。

筑牢“算力-算法”一体化基座

在规模、性能提升的同时,Intern-S1-Pro构建了原创的“算力—算法”一体化基座。模型从架构设计之初,便与昇腾AI生态确立联合研发路线,实现了从最底层的算子、编译优化到上层的训练、推理框架的深度适配。通过联合攻关,攻克了大规模训练中精度对齐、超长序列强化学习稳定性、硬件性能极致释放等一系列核心技术难题,基于XTunerV1训练框架的精细优化与LMDeploy推理引擎的高效部署,结合先进的内存管理与并行策略,确保了万亿参数模型训练的高效与稳定。通过创新的全异步强化学习框架等技术的应用,大幅提升了训练效率,降低了研发成本与门槛,为开放共享、面向未来的AGI4S基础设施奠定了坚实基础。

高质量开源赋能创新生态

自发布以来,Intern-S1多次登顶HuggingFace全球多模态榜单,累计下载超41万次,并获得近200 家科研机构和企业的合作申请。其卓越的跨模态科学理解能力不仅为科研提供了高效工具,也通过开源降低了全球科研团队迈入AGI for Science的门槛。未来,在研究范式创新及模型能力提升的基础上,上海AI实验室将推进Intern-S1及其全链条工具体系持续开源,支持免费商用,同时提供线上开放服务,与全球合作伙伴共建更加开放、高效的科学AI生态。